Initiation REC709, RAW & LOG

Bonjour à tous, à toutes.

Après une initiation à la technique fondamentale de l’étalonnage ainsi qu’une formation plus ou moins complète à DaVinci Resolve et ses fonctionnalités de colorimétrie, il est temps de franchir un pas et de s’intéresser de plus près à la technologie de couleur, au color management dans le but d’optimiser notre flux de travail, acquérir le plus de nuances possibles.

Nous entrons dans des domaines assez complexes, il va vous falloir ingurgiter pas mal de technique assez tarabiscotée, vous êtes prévenus.

Dès lors, il est inutile de suivre cette initiation si vous n’avez pas au préalable les connaissances de bases en étalonnage et l’utilisation de DaVinci Resolve, vous pouvez retrouver cela ICI et ICI.

Nous allons donc passer en revue 3 technologies d’image fondamentales très utilisées en étalonnage : Le REC709, le RAW et le LOG (LOG qui fait intervenir une autre technologie : Les LUTs)

La plage dynamique

Pour pouvoir vous parler de ces technologies d’images, il faut que je vous introduise brièvement à ce qu’est la plage dynamique.

Si vous avez bon souvenir, dans mon initiation à l’étalonnage, je vous ai parlé du principe du contraste, la différence entre le noir et le blanc et les niveaux intermédiaires que sont les niveaux de gris.

Si vous vous souvenez, ce sont en quelque sorte les gris, noirs et blancs qui vont « construire » votre image, à savoir qu’un pixel de luminosité X à côté d’un autre pixel d’une luminosité différente va indiquer un passage, un « switch » si vous voulez de luminosité.

C’est au final la différence entre chacun de ces pixels qui va faire que vous pouvez voir les objets, les éléments de votre image se dessiner. Si vous n’avez que des pixels de même valeur luminique, vous n’avez qu’une image totalement uniforme, un « gros bloc » de gris, de noir ou de blanc.

Tout pixel à la même valeur luminique/chromatique : Image totalement uniforme, ici en exemple un solide gris.

Pixel à valeur luminique et chromatique différente : Toute l’image se dessine. Ici en exemple une image du Monocaméra Bergmans de l’Atelier Beatriz Flores.

Ce qu’on appelle Plage Dynamique est en quelque sorte le nombre de nuances disponibles entre votre point noir et votre point blanc.

Plus votre plage dynamique est élevée, plus vous aurez de nuances, de détails dans vos zones les plus exposées et les moins exposées. Plus elle sera faible, moins vous aurez de détails et de séparations entre vos blancs et vos noirs, qui deviendront uniformes, clippés.

Je vais distinguer ici 2 types de plages dynamiques qu’on pourrait appeler Plage Dynamique Numérique et Plage Dynamique d’exposition.

Plage Dynamique faible : On peut voir que les arbres dans l’ombre sont très sombres et qu’on a perdu beaucoup de détails, on obtient un noir uniforme dans cette zone.

Plage Dynamique plus élevée : Même si le ciel est exposé de la même façon que l’image de gauche, on voit ici qu’on récupère beaucoup de détails dans les arbres qui s’éclaircissent. On a donc plus de nuances entre notre point blanc et noir.

SOURCE IMAGES. Ne pas hésiter à aller visiter pour une explication plus approfondie

- La plage dynamique numérique est directement liée au format d’enregistrement de votre fichier vidéo. L’exemple le plus parlant est la profondeur d’échantillonnage : Une image 8 bits est codée sur 256 niveaux de luminance. Une image 10 bits sur 1024 niveaux. On a donc en 10 bits un plus grand nombre de nuances entre nos noirs et nos blancs

- La plage dynamique d’exposition est elle directement dépendante du capteur de votre caméscope ou appareil photo et va déterminer le nombre de valeurs d’expositions que vous pourrez obtenir entre votre point le plus exposé et votre point le moins exposé.

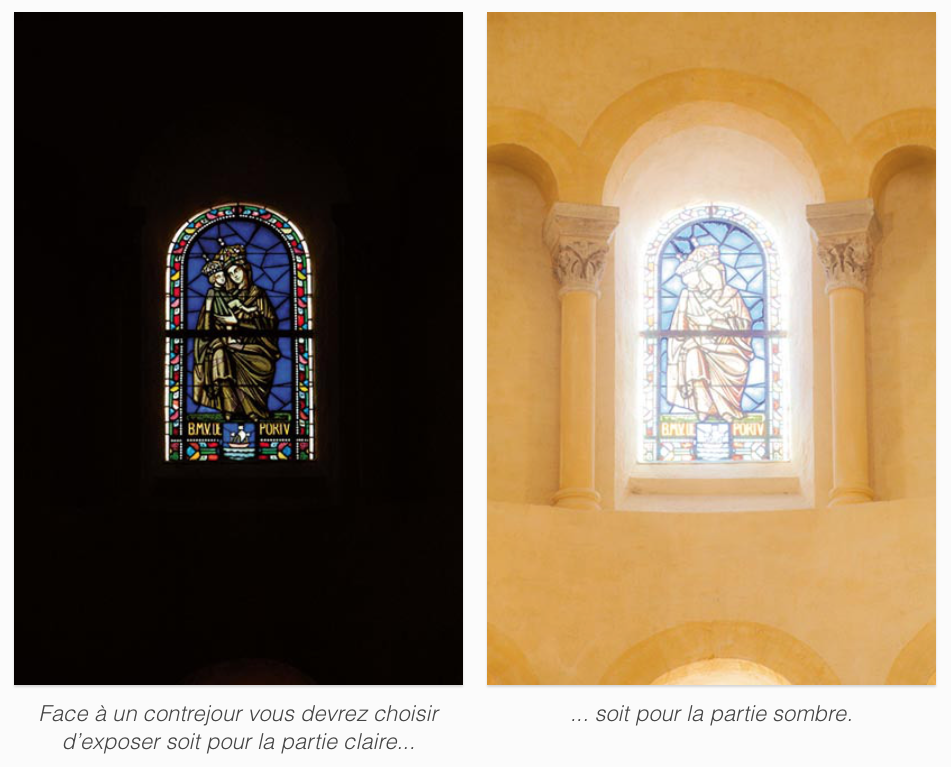

Un exemple ci-dessous avec la prise de vue d’un vitrail d’église en intérieur.

Si l’exposition est fixée sur la lumière extérieure de la fenêtre, on peut voir que l’intérieur de l’église devient totalement sous-exposé.

Si l’exposition est fixée sur la lumière intérieure, on peut voir que la fenêtre devient totalement surexposée, qu’on perds énormément de détails sur cette fenêtre.

Si nous captons la même scène avec une plage dynamique très très large (en l’occurrence ici une plage HDR), on peut arriver à obtenir la lumière extérieure et intérieure correctement exposées, sans perdre des détails dans l’une ou l’autre.

SOURCE IMAGES. Ne pas hésiter à aller visiter pour une explication plus approfondie

Ce qui va ici surtout nous intéresser pour nos workflows est la plage dynamique d’exposition. Elle est directement dépendante de votre capteur donc de votre matériel de captation et se mesure en nombre de DIAFS ou plus exactement en nombre de STOPS.

Si vous avez une plage dynamique de 1 stop, vous n’aurez qu’un blanc uniforme et un noir uniforme sur la scène que vous captez. Si par contre vous avez une plage de 13 stops par exemple (Plage dynamique de la BlackMagic Pocket Cinema Camera), vous aurez donc 13 valeurs d’expositions entre votre noir et votre blanc.

Pour mieux comprendre les STOPS et comment calculer votre exposition, je vous laisse avec David Lambot de la chaîne MR CAMERA qui explique cela ici formidablement bien.

Maintenant que vous comprenez ce qu’est la plage dynamique, vous devinez aussi son implication majeure dans l’étalonnage : Travailler sur des rushs issus d’un caméscope a grande plage dynamique vous donne un nombre important de nuances luminiques et chromatiques, un travail donc plus affiné, précis.

Voyons maintenant un premier cas de workflow, le plus courant.

Le cas du REC709

REC709 correspond à une norme d’image, précisément la norme de télévision numérique HD SDR, la plus courante en diffusion. La grosse majorité des films et émissions que vous regardez sont dans cette norme.

Vous avez peut être entendu parler de la REC601 qui elle était la norme de télévision numérique SD.

Il y a aussi la REC2020 dont vous avez sans doute eu vent qui elle correspond à une norme HDR, plus précisément la HDR Dolby Vision. Mais ça, c’est pour plus tard, on ne va pas encore parler ici des workflows HDR.

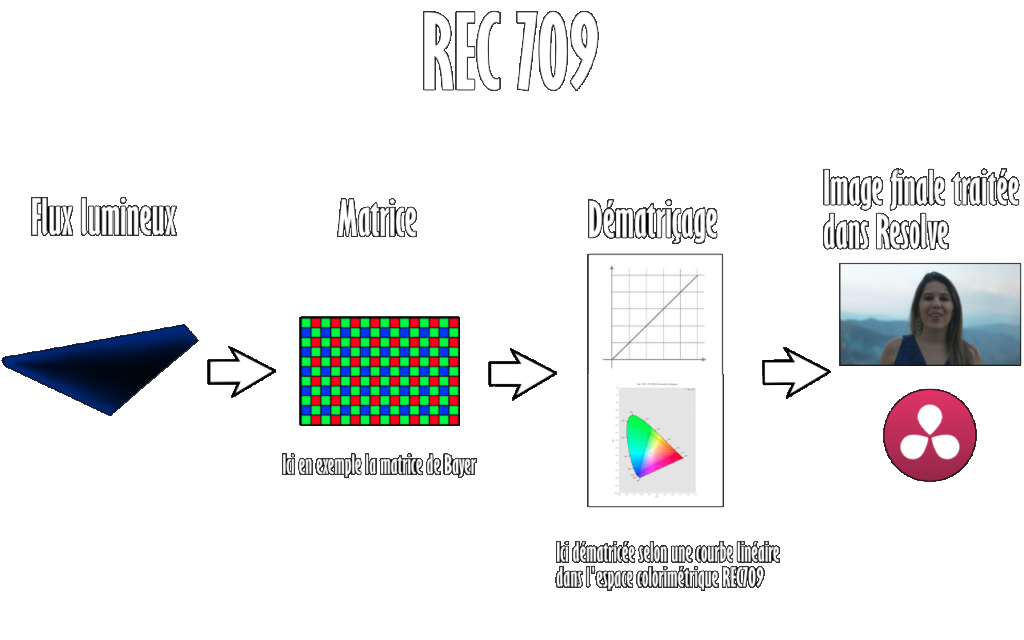

Pour détailler le principe du REC709, intéressons nous à comment se déroule une captation dans ce format au niveau de notre caméscope.

La matrice et le dématriçage

Dans l’objectif de votre caméscope entre un flux lumineux. Dans un premier temps, ce flux lumineux va être en quelque sorte « enregistré » dans une matrice.

La matrice la plus couramment utilisée est la matrice de Bayer (à droite sur l’image ci-contre) qui utilise donc 1 pixel « récoltant » les radiations rouges, 1 récoltant le bleu et 2 récoltant le vert, ce schéma se répétant.

Bien qu’il s’agisse de la matrice la plus présente, il existe d’autres types de matrices. Par exemple, une qui fait parler d’elle depuis un certain temps est la matrice des capteurs Fovéon (à gauche sur l’image ci-contre). Qui a l’intérêt de corriger le principal défaut de la matrice de Bayer (cliquez ici si vous désirez en savoir plus au sujet des Fovéon).

A ce stade, votre flux lumineux est enregistré de façon brute, intégrale. En quelque sorte comme si vous aviez en même temps l’intégralité des nuances luminiques et chromatiques que peut capter votre caméscope.

Pour obtenir donc notre image finale c’est à dire passer de ce flux lumineux brut à nos nuances luminiques et chromatiques définies, on effectue un dématriçage.

On « mélange » si vous voulez chacun des flux rouge vert et bleu enregistrés dans votre matrice et chaque pixel obtient sa nuance et construit l’image.

Ce dématriçage va se faire par votre capteur en suivant une Courbe de Gamma ou Courbe de réponse des tons (je vous en parle plus en détails plus tard) qui va répartir votre contraste et dans un espace colorimétrique ou Gamut qui va englober vos nuances de teinte et saturation.

Dans notre cas, les nuances sont encodées dans l’espace REC709 que vous voyez sur l’image ci-contre et selon une courbe linéaire. (La grande zone dans laquelle est inscrite l’espace REC709 est l’espace CIE, projection 2D de l’espace LAB qui représente l’intégralité des nuances colorimétriques que perçoit l’œil humain)

Pour clarifier un peu tout cela, voyons cela dans un schéma illustratif.

La norme de diffusion REC709 définit une image codée sur 8 bits dont les nuances sont enregistré dans l’espace du même nom, quasi identique à l’espace sRGB.

Le défaut

Le problème essentiel du REC709 en workflow natif est que l’espace colorimétrique est très petit, permettant de couvrir peu de nuances de teinte/saturation et surtout que la plage dynamique d’exposition est définitivement figée.

Ce que cela veut dire, c’est que toutes les nuances possibles n’ayant pas été prises en compte dans le dématriçage REC709 sont brûlées, irrécupérables.

Dans ce type de workflow, vous êtes totalement dépendant de la plage dynamique du capteur prise pendant la captation. Impossible de retrouver plus de nuances que ce qui a été capté/dématricé au tournage.

Pour vous illustrer cela, l’exemple le plus parlant est dans le cas d’une image sous-exposée ou surexposée, comme ci-dessous.

(l’exemple est extrême, je sais, mais c’est juste illustratif)

Comme vous pouvez le voir sur l’image de droite, notre correction de luminance haute dans Resolve n’a fait que ramener des blancs uniformes vers des gris.

Aucune nuance de contraste ou de teinte/saturation n’a pu être récupérée pour construire notre arrière-plan qui reste uniforme.

Toutes les nuances écrasées/non comprises dans notre dématriçage sont définitivement perdues.

Pour résoudre/contourner/atténuer ce problème, on peut exploiter plusieurs principes, un exemple très simple est de monter la plage dynamique numérique des fichiers enregistrés, c’est pour cela qu’on retrouve certains codecs codant les niveaux sur 10 bits au lieu de 8 voir plus, afin de « découper » en quelque sorte la plage dynamique d’exposition en plus de valeurs numériques.

Mais peut on récupérer des nuances perdues de notre exposition en post-production ?

La réponse est oui, et c’est l’objectif du RAW

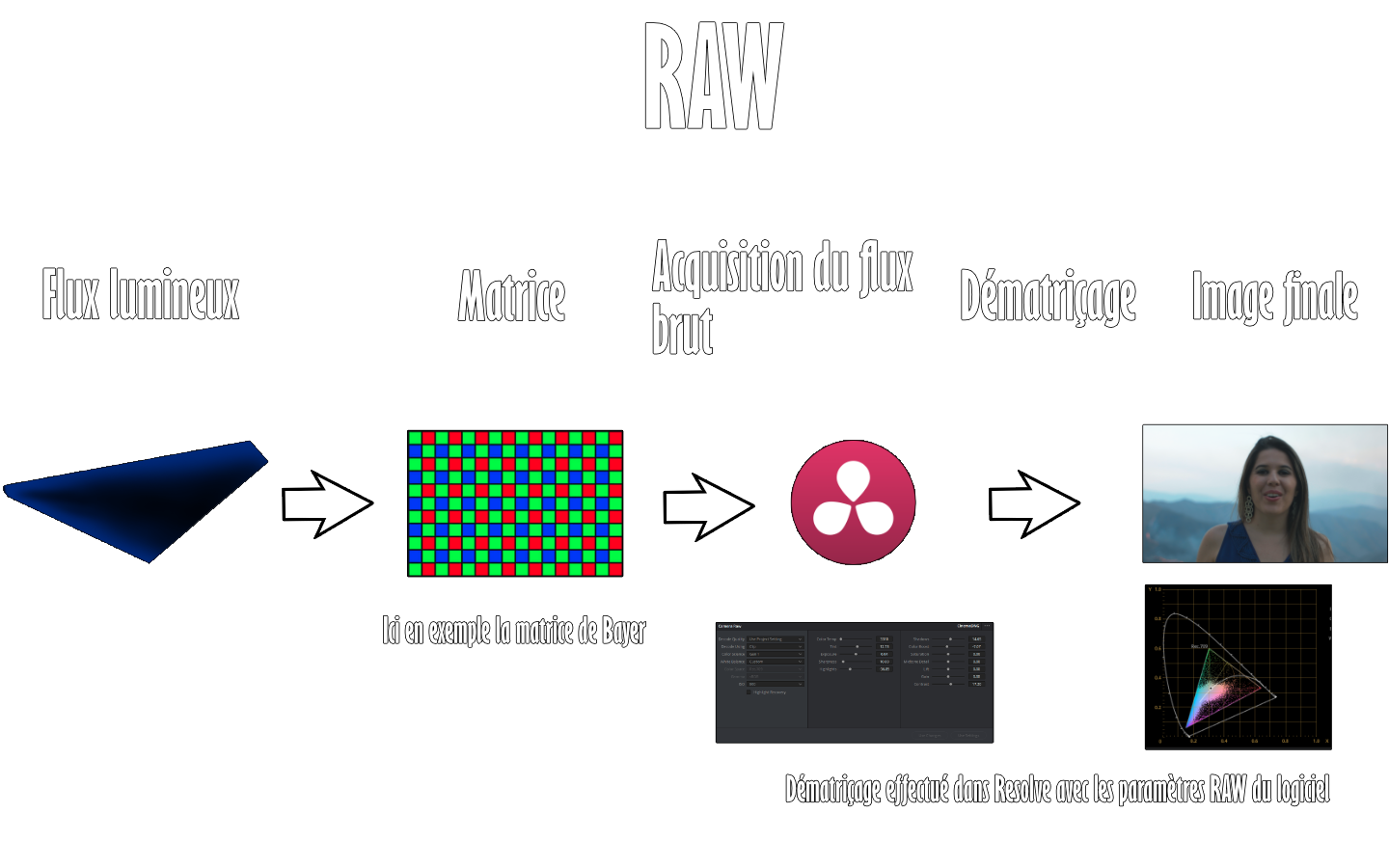

Le cas du RAW

Si vous avez bien compris, le problème du REC709 se situe au niveau du dématriçage, brûlant définitivement les données même si ces dernières peuvent être captées par notre équipement.

Quelle solution ? Conservez les données de la matrice sans les dématricer. C’est vulgairement parlant l’entièreté du principe du RAW.

Le principe

RAW signifie BRUT, indiquant que l’on conserve les données brutes de notre capteur telles qu’elles ont été enregistrées dans notre matrice.

Cependant, il est impossible d’afficher sur un écran une image brute non dématricée puisque le flux brut comprends toutes les valeurs d’exposition et de balance des teintes/saturation de notre image. C’est pour cela que :

En RAW, nous conservons les données brutes de la matrice et le dématriçage est effectué en post-production.

Pour mieux comprendre cela, un schéma illustratif :

Bien entendu, un dématriçage est également effectué sur le tournage pour que l’équipe image puisse visualiser sur les écrans du caméscope ou un moniteur le rendu de ce qu’ils capturent selon tel ou tel réglage du capteur.

La différence est que ce dématriçage n’est effectué qu’au niveau du monitoring et pas de l’enregistrement. Le fichier enregistré sur le support de stockage du caméscope contient lui le flux brut non dématricé.

Quelle conséquence de cela ?

Il devient possible de revenir sur les réglages de dématriçage du capteur dans notre logiciel d’étalonnage et/ou de montage, pour peu que ce dernier dispose du support natif des fichiers RAW du caméscope utilisé.

Comme vous pouvez le voir ici :

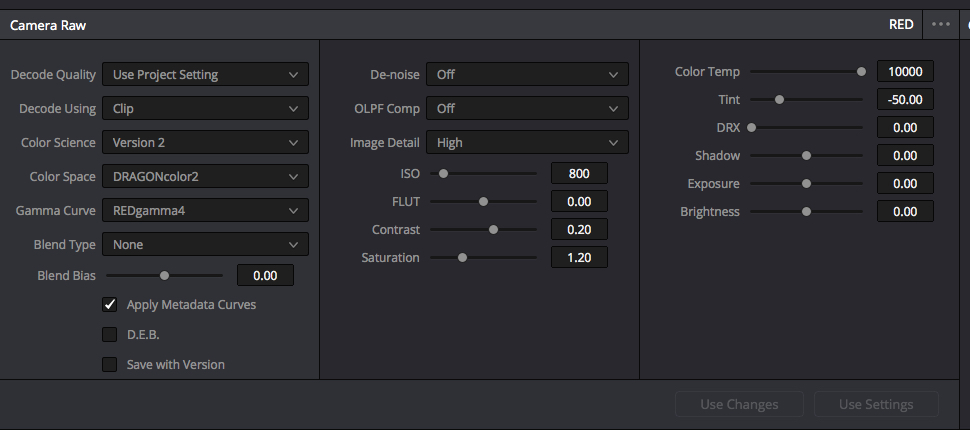

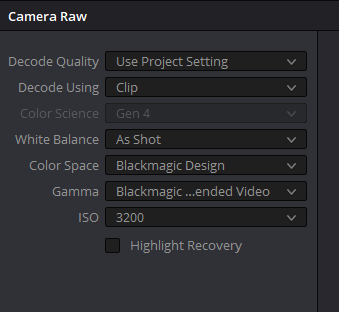

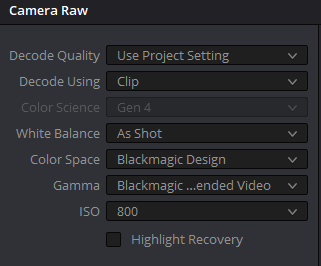

Réglages RAW dans DaVinci Resolve

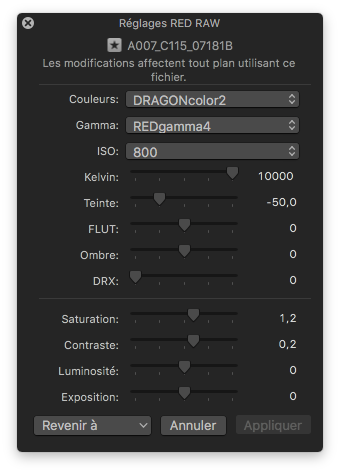

Réglages REDRAW dans Final Cut Pro

Au niveau de notre plage dynamique d’exposition, le très grand intérêt du RAW est qu’on ne perds rien des nuances des tons les plus exposés et des moins exposés car tout reste présent dans le fichier, il suffit juste de changer les réglages du dématriçage pour retrouver toutes les nuances.

En clair, reprenons notre exemple d’image surexposée et supposons qu’on ait appliqué un réglage de sensibilité de 3200 ISO au tournage, trop élevé donc provoquant la surexposition.

Comme je suis en RAW, je peux par exemple revenir à 800 ISO et retrouver une image correctement exposée, sans avoir perdu une seule nuance. Je retrouve l’intégralité des nuances dans mes zones les plus exposées.

Vous l’avez deviné, si ce plan avait été capté en REC709, les détails notamment de la robe blanche du modèle ici présent auraient été définitivement perdus. Je ne les aurais pas retrouvés en baissant la luminosité dans Resolve, obtenant juste des nuances grisâtres uniformes.

Il en va de même pour les nuances de saturation : Si vous avez sursaturé une teinte de couleur au tournage, en REC709, cette zone de couleur restera uniforme. En RAW, revenir sur les réglages de dématriçage vous permettra de retrouver les nuances de saturation.

Il semble donc que le principal défaut du REC709 soit résolu. Cependant, il y a toujours un revers de médaille (ou peut être pas dans notre cas depuis 2018, je vous en parle plus bas) dont nous allons parler maintenant

Le défaut (ou pas ?)

Le défaut majeur du RAW est très simple et va je pense vous paraître évident :

Il y a beaucoup plus d’informations dans les fichiers finaux et ces fichiers doivent être dématricés en temps réel pour pouvoir être lus.

La conséquence est que les vidéos RAW sont très lourdes et très difficiles à décoder. Il faut donc beaucoup de ressources matérielles afin de pouvoir gérer ce type de fichier, autant d’un point de vue stockage que d’un point de vue puissance et vitesse de calcul.

Plusieurs fabricants ont proposé leur propres solutions RAW, certains ont essayé également de réduire le poids des fichiers, le premier en date fut la firme RED avec un algorithme de compression losless, le REDCODE. BlackMagic Design proposa dans un premier temps les séquences d’images CineDNG.

MAIS, il y a un mais, c’est pourquoi j’ai ajouté la parenthèse « ou pas ? » : 2 codecs sont sortis récemment, codecs qui semble t’il peuvent changer la donne. C’est pourquoi je me devais d’en faire un petit aparté.

ProRes RAW & BlackMagic RAW

Je ne vais pas m’éterniser sur ce sujet, mais si vous avez suivi l’actualité broadcast ces dernières années, vous n’êtes sans doute pas passé à côté de cette information.

Apple Inc connue pour ses iPhone et Mac mais aussi dans notre milieu pour ses nombreuses technologies et logiciels, notamment Final Cut Pro et le codec ProRes a jeté un pavé dans la mare en sortant une nouvelle déclinaison de son codec : Le ProRes RAW.

BlackMagic Design a suivi en proposant le BlackMagic RAW.

Pour faire simple, le pari de ces codecs est de proposer un fichier suffisamment compressé et facile à décoder pour pouvoir être lu facilement sur une station de travail moyenne tout en ne nécessitant pas un gros espace de stockage.

Il semblerait donc que le défaut majeur des workflow RAW soit en passe d’être de l’histoire ancienne, les premiers retours paraissent très prometteurs.

Pour en savoir plus sur le ProRes RAW en plus d’un historique des différentes solutions proposées par les fabricants agrémenté d’un résumé complet de ce que je vous ai expliqué jusqu’ici :

Je vous laisse avec Erwan Le Cloirec de la chaîne YAKYAKYAK.FR qui fait ici une vidéo plus que formidable résumant le tout avec exemple d’utilisation dans FCPX.

Maintenant que vous connaissez le principe du RAW, on s’attaque à la pratique avec la gestion de votre workflow RAW dans DaVinci Resolve.

On fait tout cela bien sûr en vidéo.

Atelier pratique : RAW dans Resolve

Donc, pour vulgariser, nous avons d’un côté une solution facile à gérer mais destructive et limitée, de l’autre une solution beaucoup plus large et moins destructive mais complexe à gérer.

N’existe il pas un moyen de travailler sur un fichier vidéo dématricé mais conservant une plus grande plage dynamique, sacrifiant moins de nuances ?

La réponse est oui, c’est le but des profils LOG.

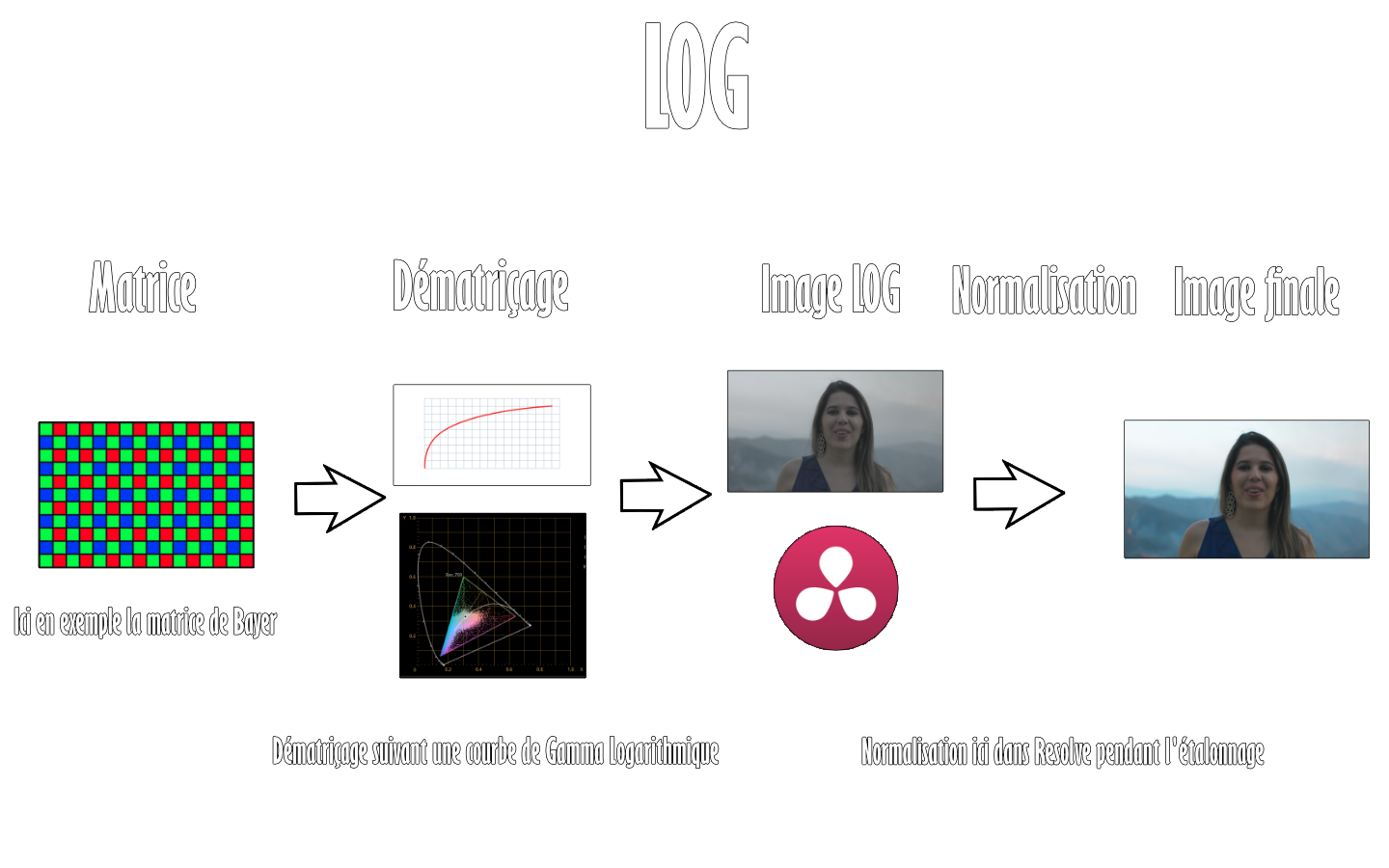

Le cas du LOG

Partons encore une fois de notre flux brut, cette fois ci, si nous voulons un fichier facile à décoder, il faut donc le dématricer.

Pour obtenir plus de nuances, on peut agir directement sur le niveau de contraste et le niveau de saturation obtenu après dématriçage.

Pour cela, on va se servir de la Courbe de Gamma du capteur et/ou éventuellement du Gamut.

Dans le cas du Gamut ou espace colorimétrique, c’est assez simple à comprendre : Si notre caméscope enregistre dans un espace colorimétrique plus large que celui du REC709, il peut donc enregistrer plus de nuances de saturations dont on disposera dans notre travail d’étalonnage.

Tout du moins simple en apparence, cela peut devenir beaucoup plus complexe quand on va dans le détail, c’est pourquoi, si vous désirez en savoir plus, je vous invite à lire ce guide complet des espaces couleurs proposé par Arnaud Frich

Pour la Courbe de Gamma répartissant le contraste, c’est beaucoup plus complexe, je me dois de vous faire un petit aparté pour vous initier à cela.

La Courbe de Gamma

Je vais prendre des libertés pour vulgariser le concept de la courbe de gamma qui n’est pas facile à appréhender, on l’appelle aussi la Courbe de réponse des tons, nom moins utilisé mais plus instructif sur sa nature.

Comment votre capteur interprète t’il le flux capté pendant le dématriçage ?

Par exemple s’il reçoit un flux de 1, restitue t’il sur l’image un blanc à 1 ou un gris à 0,5 ? (ne faites pas attention aux chiffres, je les invente, c’est pour le concept)

Même si ce qu’il reçoit reste identique, sa réponse des tons peut différer.

Ces réponses vont se répartir selon une Courbe, pour cela je vais prendre en exemple un outil similaire pour ne pas dire identique que vous connaissez si vous avez suivi ma suite de tutos sur Resolve :

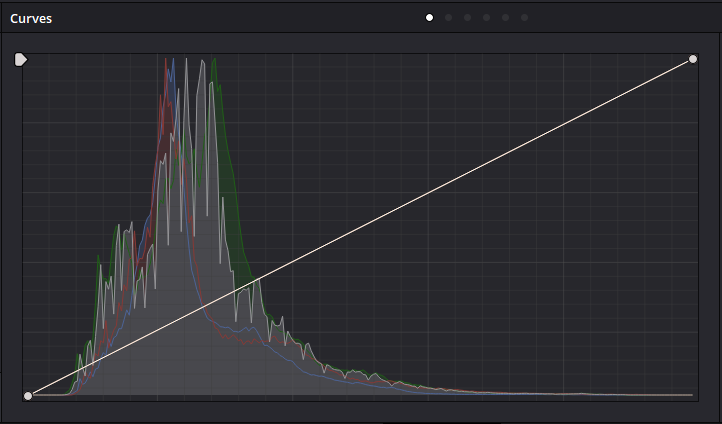

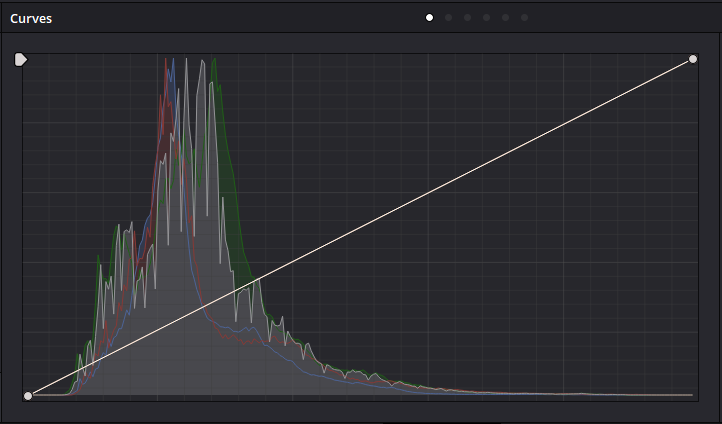

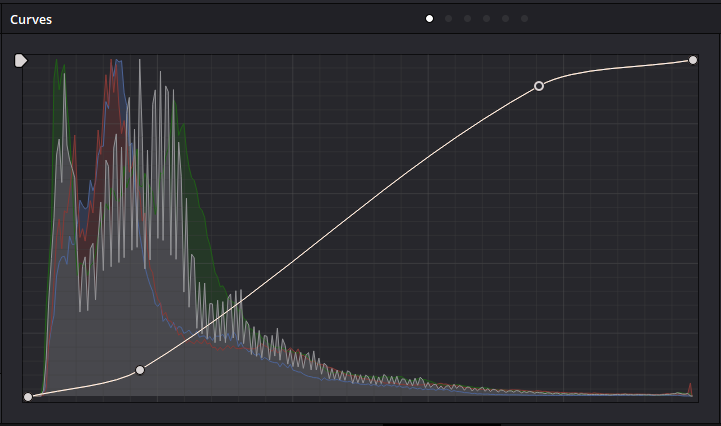

La courbe colorimétrique de Resolve se comporte en fait comme une Courbe de Gamma, sur cette courbe, le contraste et/ou la saturation sont modifiés en suivant la logique d’entrée/réponse.

Reprenons notre exemple fictif d’une valeur d’entrée de 1 et situons là dans les hautes lumière, prenons une valeur par exemple de 0,3 dans les tons sombres :

Si je suis sur une courbe linéaire, mon entrée de 1 sur l’axe X vaudra 1 sur l’axe Y, même chose pour mon 0,3 donc dans ce cas là, nos valeurs d’entrée sont identiques à la réponse des tons.

Si en revanche j’utilise ici par exemple une courbe en S. Mon entrée de 1 dans les HL sur l’axe X va être haussée en réponse sur l’axe Y par exemple à 1,3, mon entrée de 0,3 sera ramenée par exemple à 0,1.

Résultat : les noirs s’assombrissent, mes hautes lumières s’éclaircissent, mon image devient donc plus contrastée.

Courbe linéaire

Contraste de base (Image : Monocaméra OZARK – Atelier Beatriz Flores – Acteur : Aurélien LALLOUET)

Courbe en S : Réponse des basses lumières plus sombre, réponse des hautes lumières plus élevée.

Résultat : Image plus contrastée.

Vous pouvez en savoir plus sur la Courbe colorimétrique de Resolve en suivant mon tutorial dédié à cet outil.

Donc pour en revenir à la Courbe de Gamma de nos capteurs, imaginez que vous disposez d’une courbe comme celle-ci lors du dématriçage.

Si cette dernière est linéaire, vous obtiendrez un contraste de base défini par l’éclairage de votre scène, vos réglages de capteur, etc…

Si cette dernière est différente comme par exemple en S (ou autre), votre contraste bien que vous ayez les mêmes données d’entrées sera réparti différemment, suivant cette courbe. La saturation aussi bien entendu car les capteurs disposent d’une Courbe de réponses des tons pour chaque canal donc rouge, vert et bleu.

Pour en savoir plus sur la Courbe de Gamma, vous pouvez encore une fois suivre ce guide complet écrit par Arnaud Frich.

ATTENTION, cependant, facteur de confusion : Arnaud parle ici des corrections Gamma de nos écrans (Gamma 2.2, 2.4, 2.6), pas des courbes au niveau de nos capteurs mais le principe reste fondamentalement le même.

Maintenant que vous avez une idée plus ou moins convenable de ce qu’est la courbe de Gamma, voyons notre image LOG.

Le principe

Dans le cas d’une image à profil LOG, nous allons dématricer notre image non pas suivant une courbe linaire, mais une courbe dite Logarithmique. (D’où le nom LOG).

Quel résultat ?

Voici l’exemple d’une image tournée en profil LOG BlackMagic Cinema Camera

Chaque Courbe de Gamma LOG va avoir ses spécificités/résultats selon le fabricant (Slog chez Sony, Vlog chez Panasonic,… etc) mais l’objectif général reste le même :

Rendre l’image la moins contrastée et la moins saturée possible.

Dans quel but ?

Faire rentrer le plus possible de nuances luminiques et chromatiques dans le signal

On peut dire en quelque sorte qu’on a réduit notre signal afin que les zones les plus exposées ne s’écrêtent pas ou moins au dématriçage, les moins exposées ne s’écrasent pas en sortie, même chose pour les zones fort saturées.

Quel intérêt au niveau de notre plage dynamique d’exposition ?

Reprenons ici notre image LOG normalisée (je vous en parle juste après) vers le REC709.

Imaginez que nous ayons capté cette image en REC709 natif, les zones les plus exposées de mon ciel en haut à gauche seraient écrêtées, je n’aurais jamais pu retrouver les nuances dans cette zone.

Mais comme ici nous avons capté en LOG, ces nuances ont bien été dématricées sans être écrêtées et sont présentes dans mon signal, je les retrouve donc.

Vous comprenez donc que les images au profil LOG nous permettent de gagner virtuellement quelques stops de plage dynamique.

Petite parenthèse : C’est pour cela aussi que vous entendrez certains fabricants ou autre dire que les profils LOG permettent de retrouver la souplesse de la pellicule.

En effet, les anciens supports argentiques (comme les pellicules 35mm) disposaient d’une plage dynamique très élevée, bien plus élevée que la plupart des capteurs numériques encore actuellement. Comme ici on gagne virtuellement en plage dynamique, on se rapproche en quelque sorte des anciens supports argentiques.

Cela dit, tout n’est pas rose (c’est le cas de le dire ^^) avec notre image LOG, non ? Il n’y a pas quelque chose qui vous fait tiquer quand vous regardez notre image LOG du dessus ?… Je pense que si… On va en parler maintenant.

Le défaut (ou presque)

Pour faire simple, vous pouvez voir que notre image LOG si elle est très intéressante pour les nuances qu’elle contient n’est pas très intéressante pour son esthétique.

En effet, ces images sont très laiteuses et ternes, tristes en fin de compte. Surtout qu’en plus, le rendu en LOG ne correspondra pas forcément à ce que souhaite l’équipe image au tournage.

C’est pour cela que dans le cas du workflow LOG s’ajoute une étape : la Normalisation

Le processus de normalisation consiste à réhausser le contraste et la saturation afin que l’image redevienne dans un contraste/saturation neutre et équilibré, correspondant aux standards de la sortie finale.

En quelque sorte, on peut dire que normaliser un plan LOG est le ramener vers une colorimétrie comme si ce plan avait été filmé en REC709 si notre sortie est REC709.

Comme l’exemple ci-dessous où mon plan filmé en LOG a été normalisé vers le REC709 par une LUT de conversion (je vous en parle plus bas)

C’est de cela dont il est question quand vous entendez parler de conversions REC709, on parle en fait du processus de normalisation, comme le REC709 est le standard universel vidéo en web et télévision, on fait très souvent des normalisations vers cette colorimétrie.

Cela dit, j’ai dit le défaut ou presque, car beaucoup d’outils ont été développés pour faciliter la normalisation des plans LOG qui n’est plus vraiment un problème, au contraire ces derniers ont offert des possibilités pour transiter vers des résultats finaux de colorimétrie pouvant être très intéressants.

La normalisation peut notamment s’opérer :

- par correction manuelle

- par mire Color Checker

- par Gestion de Couleur

- par LUT de conversion

La Normalisation

La correction manuelle

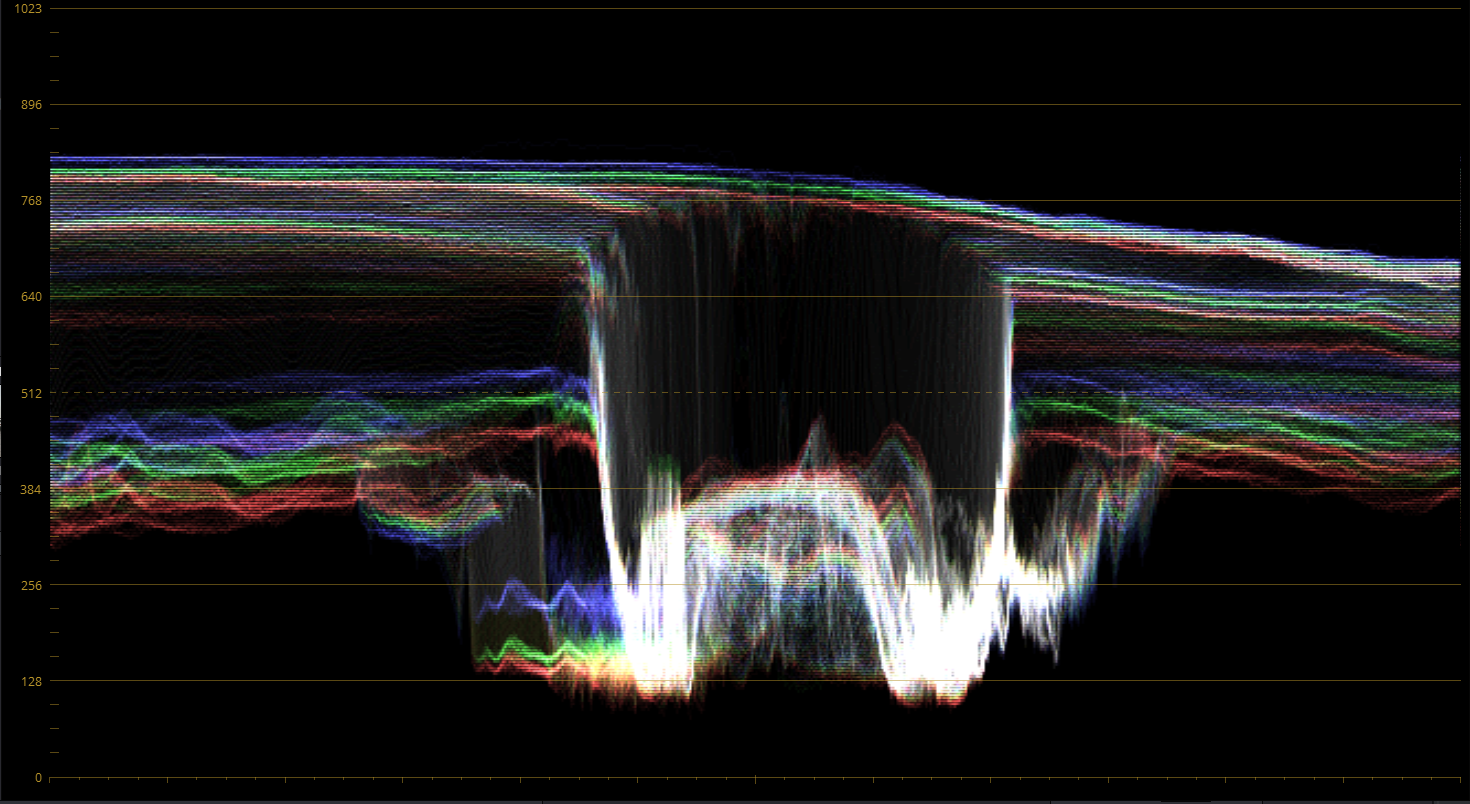

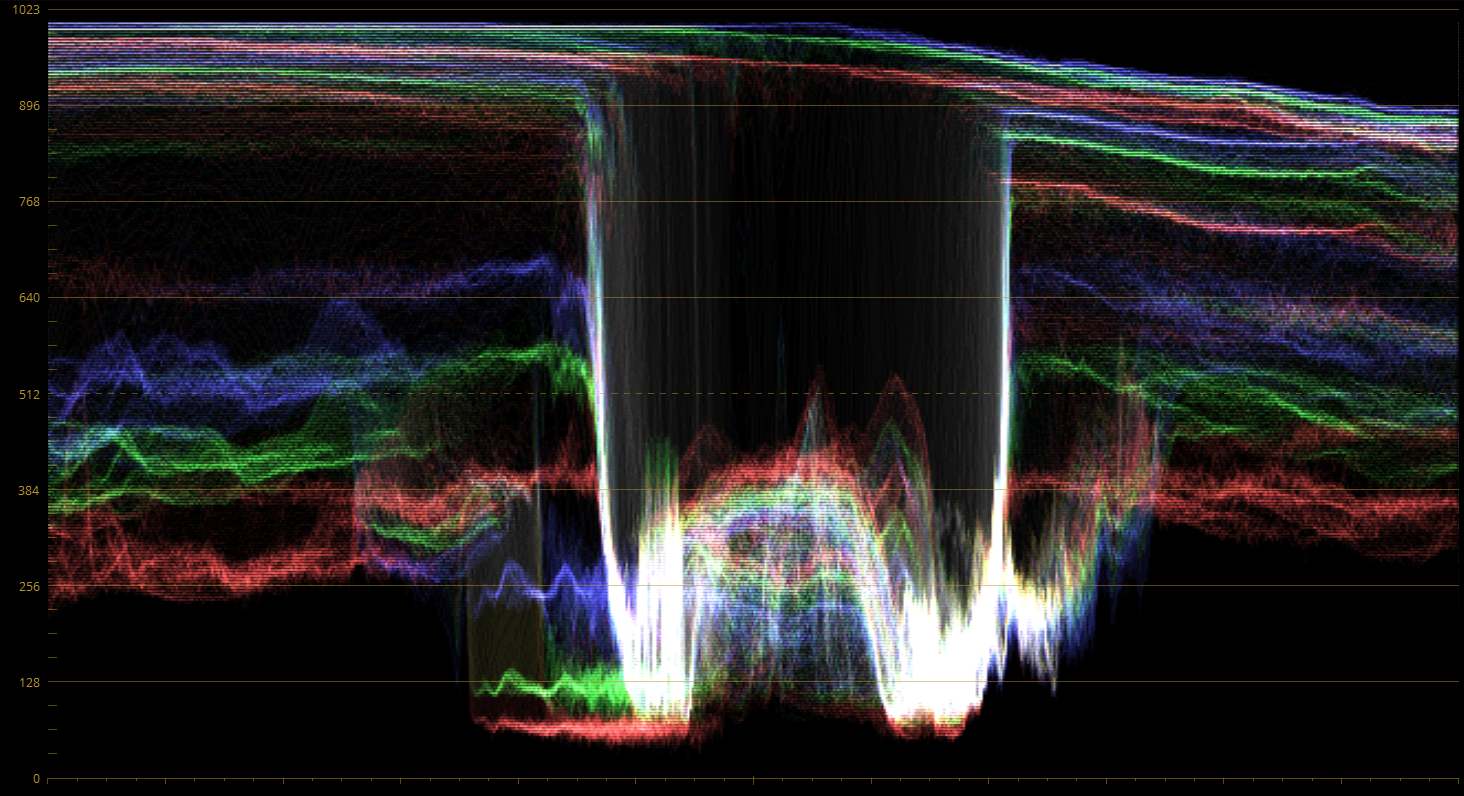

Je ne vais pas m’étendre sur le principe de la normalisation manuelle, si vous avez suivi mes tutos Resolve, vous comprenez de suite : Il s’agit simplement de fixer votre contraste et votre saturation par les outils de Resolve comme les roues ou les courbes, en vous référant au Waveform ou à la Parade.

Rien de plus simple dans ce cas ci.

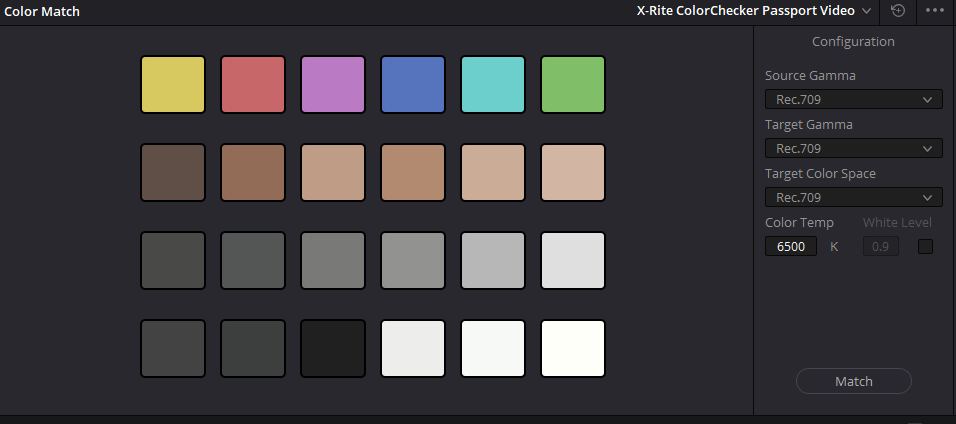

Les Mires Color Checker

Les mires Color Checker sont des sortes de tableaux affichant des couleurs de références, vous en avec un exemple ici avec le Passeport 2 d’X-Rite.

Quel est le principe ? Rien de plus simple : au tournage, on filme quelque seconde notre mire avant de tourner le plan.

Une fois dans Resolve, on va utiliser un outil dédié, le Color Match, dans lequel on va retrouver la référence de notre mire.

On définit à ce moment comme vous pouvez le voir sur le côté quelle est la courbe de Gamma/le Gamut d’entrée de notre plan et vers quelle courbe de Gamma/espace colorimétrique on souhaite normaliser.

Une fois cela fait, on utilise un outil visuel pour indiquer à Resolve précisément les points de repères de notre et mire et hop, on matche, c’est normalisé.

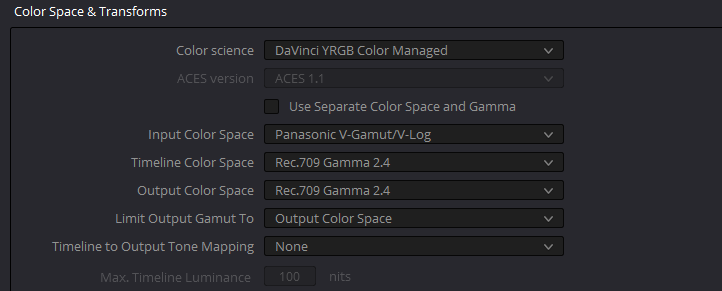

La gestion de couleur (Color Management)

Les logiciels d’étalonnage professionnels disposent dans leurs paramètres des options de définition d’espace couleur ou Gamma d’entrée, de travail, de sortie.

C’est le cas de DaVinci Resolve qui permet comme vous le voyez sur l’image ci-contre de définir des Courbes de Gamma ou des Gamuts à l’entrée de vos plans, comment il va les gérer dans la timeline pour finir à comment les afficher en sortie.

Dans notre cas de normalisation REC709, il suffit de définir notre Courbe de Gamma/Gamut LOG dans l’espace d’entrée et sortir en REC709 pour avoir nos plans normalisés automatiquement.

Les LUTs de conversion

Impossible de ne pas parler des LUTs de conversion dans cette initiation qui ont rencontré un très grand succès autant chez les étalonneurs que chez les directeurs photos.

LUT sont les initiales de Look-Up Table ou en français Table de Matrice.

Table de Matrice, oui, parce qu’elles font référence à une colorimétrie obtenue après tel ou tel dématriçage.

En gros, une LUT va fonctionner sur 3 Courbes correctrices RVB un peu comme notre Courbe de Gamma pour appliquer une modification générale de notre signal couleur.

Les fabricants de caméscopes se sont servi de cette technologie en priorité, notamment en proposant gratuitement ou non des LUTs de conversion calibrées pour leur propre profil LOG vers des colorimétries de sortie comme le REC709 ou autre. (Slog2 vers REC709, VLogL to Rec709,… etc)

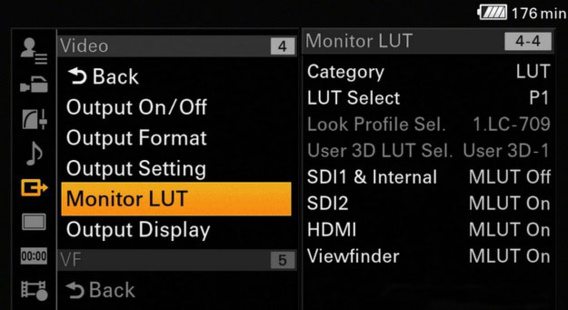

Les LUTs ne vont pas être utiles que dans notre cas d’étalonnage, c’est aussi une technologie très utilisée en tournage pour que l’équipe image même si elle tourne en LOG puisse voir sur les moniteurs de contrôle le résultat obtenu après normalisation.

On applique ici donc une LUT de monitoring sur le LCD de la caméra ou le moniteur de contrôle et même si l’enregistrement se fait en LOG, ils peuvent voir sur le moniteur l’image correctement contrastée et saturée

L’intérêt des LUTs ne va pas se limiter à la normalisation.

Leur force est qu’elles sont très légères, très facile à appliquer, à créer et à décoder.

Comme elles permettent selon le type de LUT de se rapprocher d’une colorimétrie obtenue par tel ou tel dématriçage, on peut s’en servir pour par exemple se rapprocher d’une colorimétrie obtenue si on avait tourné avec tel ou tel caméscope.

On peut également s’en servir dans le processus créatif de l’étalonnage, notamment si par exemple on aime bien le rendu que nous avons obtenu avec notre étalonnage sur un plan quelconque dans Resolve, on peut très facilement enregistrer une LUT utilisable dans tout logiciel gérant les LUTs comme Premiere, FCPX, Edius,… (contrairement aux Stills de Resolve qui ne fonctionneront que dans ce dernier), il suffira de la réappliquer sur tous les plans qu’on veut pour tenter de retrouver la colorimétrie obtenue avec ce plan.

Cependant, attention :

Les LUTs ont des défauts, notamment le fait qu’elles sont indépendantes des données d’entrée. (Contrairement au Color Checker par exemple)

Ce que cela signifie, c’est qu’elles effectueront toujours la même modification du signal couleur quel que soit le plan sur lesquelles elles sont appliquées.

Par exemple, la calibration des LUTs du signal LOG vers le REC709 par les fabricants s’est faite en prenant des scènes d’exemple en référence. Votre scène filmée n’aura pas forcément le même éclairage, les mêmes réglages,… bref, vos données d’entrées ne sont pas identiques, la normalisation par LUT ne fonctionnera donc pas toujours parfaitement.

Même chose pour vos LUTs de style personnalisée, si cette LUT a parfaitement fonctionné sur un plan, ça ne va pas forcément fonctionner pour un autre. Il faudra à ce moment utiliser votre LUT comme guide, pas comme résultat définitif.

Un autre défaut est que selon la conversion de signal qu’elles appliquent, leurs résultats peuvent être destructifs, notamment si elles définissent que les niveaux situés entre telle ou telle zone doivent tous être ramené à un seul niveau, mais je vous en parlerai plus en détails dans notre atelier pratique.

Pour conclure, notre schéma illustratif cette fois d’un workflow LOG

Maintenant que vous avez je pense plus qu’assez lu de théorie, on passe à l’atelier pratique de vos workflow LOG dans DaVinci Resolve, en vidéo cette fois.

Atelier pratique : LOG dans Resolve

Et on arrive ENFIN à la fin de cette initiation, qui fût longue et harassante à écrire, je suis sûr qu’elle n’a pas dû forcément être facile à lire non plus.

Merci à tous de m’avoir suivi.

Je tiens bien entendu à remercier messieurs Arnaud Frich, Erwan Le Cloirec et David Lambot pour leur vidéo et contenu qui m’ont aidé à étayer cette initiation.

[…] Si vous ne comprenez pas de quoi il est question, il vous est recommandé de suivre cette initiation dédiée. […]